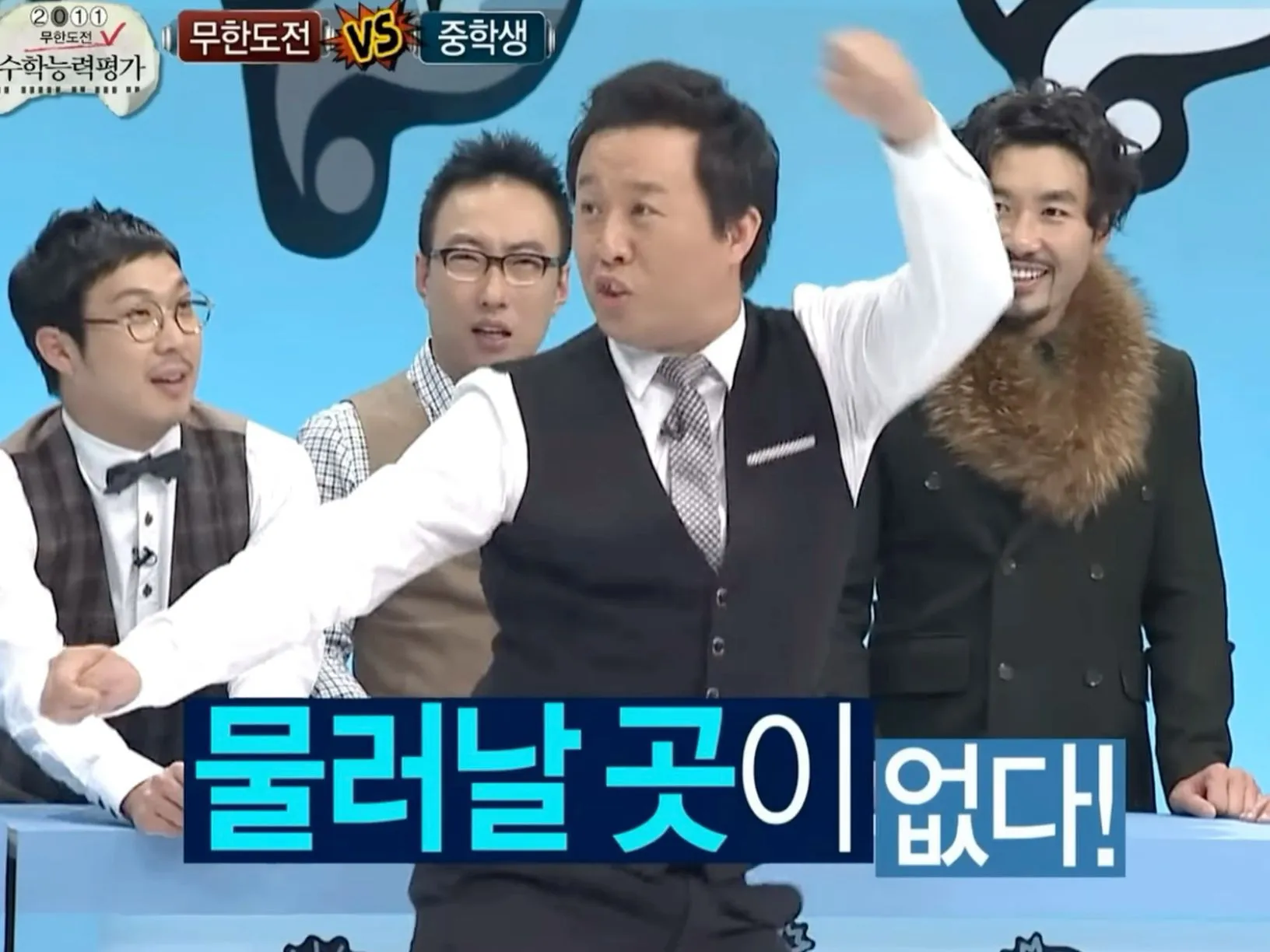

이제는 더 이상 물러날 곳이 없다

이제는 더 이상 물러날 곳이 없다

« 2025/04 »

| 일 |

월 |

화 |

수 |

목 |

금 |

토 |

| |

|

1 |

2 |

3 |

4 |

5 |

| 6 |

7 |

8 |

9 |

10 |

11 |

12 |

| 13 |

14 |

15 |

16 |

17 |

18 |

19 |

| 20 |

21 |

22 |

23 |

24 |

25 |

26 |

| 27 |

28 |

29 |

30 |

|

|

|

단축키

내 블로그

| 내 블로그 - 관리자 홈 전환 |

Q

Q

|

| 새 글 쓰기 |

W

W

|

블로그 게시글

| 글 수정 (권한 있는 경우) |

E

E

|

| 댓글 영역으로 이동 |

C

C

|

모든 영역

| 이 페이지의 URL 복사 |

S

S

|

| 맨 위로 이동 |

T

T

|

| 티스토리 홈 이동 |

H

H

|

| 단축키 안내 |

Shift + /

⇧ + /

|

* 단축키는 한글/영문 대소문자로 이용 가능하며, 티스토리 기본 도메인에서만 동작합니다.